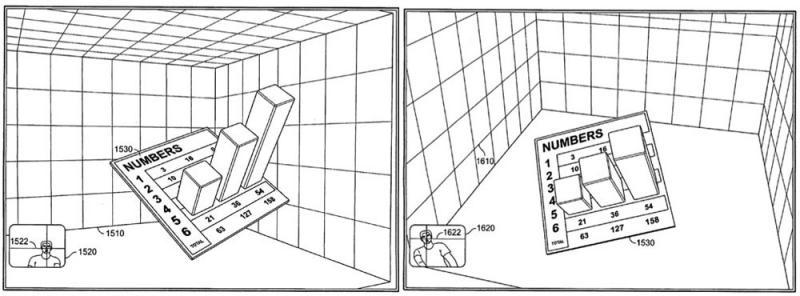

Einer Arbeitsgruppe des Informatics Laboratory von Grenoble hat eine Applikation für das iPhone und das iPad vorgestellt, die auf dem Display einen dreidimensionalen Eindruck erzeugt. Jeremie Francone und Laurence Nigay vom Engineering Human-Computer Interaction (EHCI) nutzen Gesichtserkennung und –verfolgung, um das Bild in Abhängigkeit von der Betrachterposition darzustellen. Durch das Hin- und Herbewegen des Gerätes erscheinen auf diese Weise die Objekte auf dem Bildschirm räumlich (Bewegungsparallaxe).

Heutige Computersimulationen greifen auf die Zentralperspektive zurück, die bereits in der Frührenaissance entwickelt wurde. In seinem Werk De Pictura (Über die Malkunst) von 1435/1436 beschrieb Leon Battista Alberti die Grundlagen der Perspektive als den Schnitt der Bildebene durch die Sehpyramide. Dabei konnte er auf die Arbeiten von Filippo Brunelleschi und Masaccio zurückgreifen und legte die Grundlage für die Entstehung eines Bildraumes in der Kunst, der den Realraum erweitert. Zahlreiche Künstler der Renaissance über Künstler des Manierismus und des Barock bis in die digitale Gegenwart bauen darauf auf.

Kritikpunkt war jedoch stets die Fixierung des Blicks. So lässt ein Bild in der Zentralperspektive nur einen einzigen Betrachterstandpunkt zu. Zuweilen wurde dies sogar mit Ideologiekritik in Zusammenhang gebracht. Jacques Lacan hält das Prinzip der Zentralperspektive gar für eine totalitäre Bildform. Fakt ist: Wie in Dürers Apparatur zur Bildproduktion deutlich wird, bietet das statische perspektivische Bild nur einen bestimmten Blickwinkel an. Bewegt sich der Betrachter, liegen der virtuelle Fluchtpunkt des Bildes und der reale Fluchtpunkt nicht mehr übereinander. Zudem geht die Perspektivkonstruktion stets von einem Blickpunkt, also von einem Auge aus. Es ist also eine statische Projektion eines dreidimensionalen Raums auf eine zweidimensionale Fläche.

|

| Illustration zu Albertis Bildtheorie aus Brook Taylor: New principles of linear perspective, 1719 |

Die Computergrafik hat es von jeher verstanden, die Prinzipien der Zentralperspektive auf den Bildschirm zu bringen. Jedes Wireframe-Modell simuliert nichts anderes als Albertis Schnitt durch die Sehpyramide. Das Neue ist, dass dieses Bild nun interaktiv ist. Lange Zeit war die Maus oder der Joystick das Standardinterface zur Bildmanipulation, wie Ego-Shooter eindrücklich zeigen. Mit der der Bildgenerierung in Abhängigkeit der Augenposition wird hier ein neues Paradigma eröffnet: Der Blick entscheidet über das Bild.

Update: Apple benutzt den Effekt mithilfe des Lagesensors für das Hintergrundbild seit iOS7.

Update: Apple benutzt den Effekt mithilfe des Lagesensors für das Hintergrundbild seit iOS7.

Keine Kommentare:

Kommentar veröffentlichen